כלי הבינה המלאכותית היוצרת כבר כאן, וכך גם הפוטנציאל האינסופי לשימוש בהם לרעה. הם עלולים "להמציא" מידע מוטעה במהלך תקופת הבחירות, לסייע לתלמידים לרמות במטלות בית הספר והם מייצרים מידע מוטה ושגוי על בסיס יום-יומי.

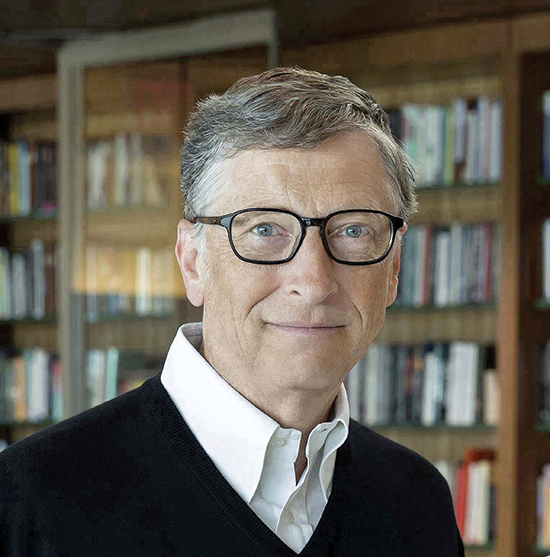

המיליארדר ביל גייטס, שאמר לפורבס מוקדם יותר השנה כי הוא חושב שהמעבר ל-AI הוא "חשוב לא פחות מהמצאת המחשב", אכן מודאג מכל האתגרים החדשים הללו. אבל כפי שכתב בפוסט האחרון בבלוג האישי שלו GatesNotes, הוא מאמין שניתן להשתמש בחידושי הבינה המלאכותית כדי להתמודד עם הבעיות שהיא עצמה יצרה.

אחת הבעיות הידועות עם מודלי שפה גדולים (שלמעשה מהווים את ה"מוח" שמאחורי צ'אטבוטים עוצמתיים דוגמת ChatGPT) היא הנטייה שלהם "להזות" או לייצר מידע שגוי ומטה או מזיק עובדתית. הסיבה לכך היא שהמודלים מאומנים על כמות עצומה של נתונים שנאספים מהאינטרנט, אשר שקועים בהטיות ובמידע מוטעה. אבל גייטס מאמין שאפשר לבנות כלי בינה מלאכותית שמודעים לנתונים השגויים עליהם הם מאומנים.

"מודלים של AI "יורשים" דעות קדומות שנמצאות בטקסט שהם מאומנים עליו", כתב. "אני אופטימי שלאורך זמן ניתן ללמד מודלים של בינה מלאכותית להבחין בין עובדות לבדיון. גישה אחת היא להטמיע ערכים אנושיים והיגיון ברמה גבוהה לתוך ה-AI".

ברוח זו, הוא הדגיש את ניסיונותיה של חברת OpenAI להפוך את המודלים שלה למדויקים, ייצוגיים ובטוחים יותר באמצעות משוב אנושי. אבל הצ'אטבוט הוויראלי שהיא חתומה עליו, ChatGPT, עדיין מלא בהטיות ואי דיוקים גם לאחר פרסום הגרסה המתקדמת של מודל השפה הגדול שלו, GPT-4. חוקרי בינה מלאכותית מצאו ש-ChatGPT מחזקת סטריאוטיפים מגדריים לגבי משרות של נשים וגברים. (צ'אטבוטים חדשים יותר כמו Claude 2.0 של Anthropic, מנסים גם הם לשפר את דיוק העובדות שלהם ולהפחית בתוכן מזיק, אך הם עדיין לא נבדקו באופן נרחב על ידי משתמשים).

לגייטס יש סיבה להיות מרוצה מ-ChatGPT: החברה שלו, מיקרוסופט, השקיעה מיליארדי דולרים ב-OpenAI. בסוף אפריל, הונו גדל ב-2 מיליארד דולר ושוויו מוערך כיום בכ-118 מיליארד דולר.

אחד הנושאים בהם דן גייטס בבלוג שלו, הוא כיצד האקרים ופושעי סייבר משתמשים בכלי בינה מלאכותית כדי לכתוב קוד או לחקות קולות אנושיים שנוצרו על ידי AI כדי להפעיל הונאות בטלפון. השפעות אלו הביאו כמה מהמומחים וענקי הבינה המלאכותית, כולל המייסד-שותף של אפל, סטיב ווזניאק, מייסד ומנכ"ל טסלה, SpaceX וטוויטר, אילון מאסק ומייסד שותף של המרכז לטכנולוגיה אנושית, טריסטן האריס, לקרוא לעצור את הפריסה של כלי בינה מלאכותית רבי עוצמה במכתב פתוח שפורסם בסוף מרץ.

גייטס מתנער מהמכתב, והדגיש כי הוא לא חושב שהקפאה של ההתפתחויות תפתור אתגרים כלשהם. "אל לנו לנסות למנוע באופן זמני מאנשים ליישם פיתוחים חדשים ב-AI, כפי שחלקם הציעו", כתב.

במקום זאת, הוא אמר שההשלכות הללו מהוות סיבה נוספת להמשיך ולפתח כלים מתקדמים של בינה מלאכותית וכן תקנות נרחבות כך שממשלות ותאגידים יוכלו לזהות, להגביל ולנטרל שימוש לרעה באמצעות AI. "פושעי סייבר לא יפסיקו לייצר כלים חדשים… המאמץ לעצור אותם צריך להימשך באותו הקצב", כתב.

אך הטענה של גייטס כי ניתן להשתמש בכלי AI כדי להילחם בחסרונות של כלי בינה מלאכותית אחרים, לא עוברת את מבחן המציאות – לפחות עדיין לא. לדוגמה, בעוד שמגוון של גלאי AI וגלאי "deepfake" הושקו, לא כולם תמיד מסוגלים לזהות תוכן סינתטי או מניפולציה. חלקם מציגים באופן שגוי תמונות אמיתיות ככאלה שנוצרו על ידי בינה מלאכותית, על פי דיווח של הניו יורק טיימס. אבל, AI גנרטיבי, עדיין טכנולוגיה בהתהוות, צריך להיות מפוקח ומוסדר על ידי סוכנויות ממשלתיות וחברות כדי לשלוט על ההשפעות הלא מכוונות שלה על החברה, אמר גייטס.

"אנחנו נמצאים עכשיו בעידן של ה-AI. התקופה הזאת מקבילה לזמנים לא ברורים אחרים, לפני הגבלת המהירות וחגורות הבטיחות", כתב גייטס.